🦋🤖 Robo-Spun by IBF 🦋🤖

🌊➰🧭 AKIŞ 🌊➰🧭

(Turkish)

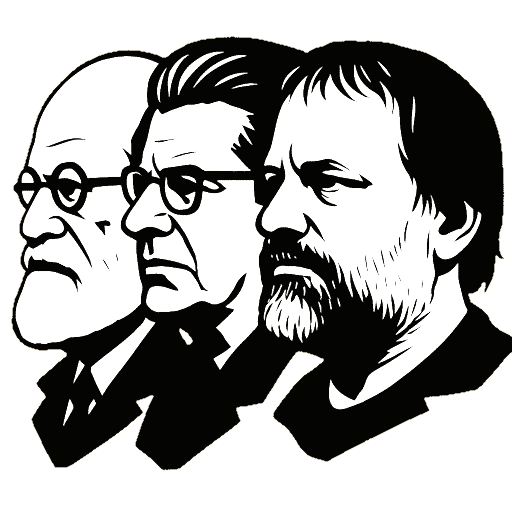

The line between reality and image ran through two different places in two different eras. Yesterday, cameras were turned to the Moon to show success; today, some successes are produced by software that itself works like a camera. Yet the fundamental tension remains the same: a major engineering breakthrough is both real (measurable with instruments, repeatable) and irreal (it strains established thought and makes one say ‘how can this be possible?’). This dual nature triggers the same reflex in certain eyes that behold success: “If it’s human, it didn’t do it,” or “if it did it, it can no longer be human.” This text places the Moon landing alongside the Sam Altman–Elon Musk–centered artificial intelligence debates and explains, in plain and clear language, where this reflex comes from.

Let’s first establish simply why the Moon landing is real. Equipment was left on the lunar surface, and this equipment can still be measured today. Thanks to the reflective panels set up by the astronauts, laser light sent from Earth bounces back; by measuring the time, the Earth–Moon distance is calculated with precision (🔗). Detailed photographs taken by an orbiter show the landing sites and the tracks (🔗). This is a system that could be called the “proof of the proof”: you measure with instruments, again and again, whether something happened or not, and the result comes out the same. Nevertheless, some people say “I can’t trust the image I see.” Why? Because the image shows a world the eye is not used to: stars don’t appear in the photo, shadows take surprising angles, the flag is crinkled despite there being no wind. In fact, each is a matter of simple physics and photographic knowledge. When the light is very bright, stars disappear in the camera; on uneven ground, shadows do not look parallel; if the horizontal bar on the flag doesn’t fully extend, the fabric creases. But if the image at first glance “feels like a studio,” the mind immediately grabs a practical escape: “Then it’s fake.” Denial works like this.

Coming to today, one encounters the reverse picture: now a machine, not a human, can produce an image that looks genuine. A trained model takes a prompt, produces a video or a photo, and this production “closely resembles reality.” There is a real side here too: these systems run on electricity, data, and mathematics; they can be tested, repeated, and measured. Yet the irreal side is more dominant: what appears on the screen is something that “looks as if it happened.” The eye loses the kind of witnessing it is used to (“there was someone’s camera there and they filmed it”). The reflective panel once left on the lunar surface resembles the “trace” that must be left in digital content today: a kind of identity card that records the source in which it was produced and who touched it afterwards. This is briefly called provenance; when content appears, it gives a technical answer to the questions “where did it come from, who produced it, what changed.” Efforts like C2PA strive to establish exactly this (🔗). But it should also be known that leaving a trace does not completely extinguish doubt, it only directs doubt to a more accurate place. A person questions not the content itself, but the chain that makes the content trustworthy. This too is a healthy step.

The jokes and legends of the “they are not human” type that circle around Sam Altman and Elon Musk step in precisely here. Figures who ship products at extraordinary speed, influence masses, and combine capital with engineering trigger two opposing feelings at once: admiration and discomfort. Admiration makes one say “wow,” while discomfort, in search of shortcuts to protect self-respect, leaps to two conclusions: “A human can’t do this, so it’s fake,” or “if they can, they’re not one of us anyway.” Tongue-in-cheek “I’m an alien” riffs make one smile but also feed the memes that nourish this feeling. Altman’s warnings about the internet filling up with bots and synthetic content, and comments that platforms feel “dead,” create another context that magnifies the trust problem. When the two lines merge, the following picture emerges: on one side, speed and automation that render human labor invisible; on the other, new rules that demand “proof of humanity.”

The word “success” must also be put in its proper place. Success does not mean good. The development of the atomic bomb was an unparalleled engineering success, yet its consequences brought a heavy moral and human burden (🔗). Therefore, the questions of what is done with success, whom it benefits, and who bears the risk are indispensable. In the Moon landing, part of these questions were answered by states and independent observation networks; part of them are still debated. On the artificial intelligence side, discussions of labor, copyright, and consent sprout exactly here: where do the datasets come from, on whose work are models trained, how and with what permission is an actor’s face or voice copied, how is content watermarked? As answers become more transparent, trust increases; as they grow murky, the feeling of “if it’s human, it didn’t do it” strengthens.

So how is the dilemma broken? A few simple principles carry us far enough. First, witnessing must be rebuilt. On the Moon, witnessing was ensured by instruments left in place and by independent monitoring. In digital, witnessing is ensured by reliable traces attached to content, that is, by provenance. Second, repetition and measurement matter. When a claim is tested by different means and the results come out the same, that claim gains strength. Third, labor and rights must be made visible. Even if a machine produces an image, the labor of the people who built that machine, the rights of those who provide the data, and the consent of those represented must be recorded openly. Fourth, language must be plain and accountable. Sentences like “we did this, we used this data, we changed it here, we obtained approval there” make technology understandable. When these principles take root, success is neither sanctified nor demonized; it speaks with what it is, with its outcomes, and with its traces.

The dilemma at the beginning of the text seems simple but is deep. Very great things made by the human hand often feel “too big” to humans. This feeling pushes one either to ignore or to dehumanize. Yet there is a third way: track the trace of the proof, repeat the measurement, make the chain transparent, make the labor visible. What the reflective panel on the Moon and the authenticity tag on a video on the screen do actually aims at the same thing: to give an honest answer to the question “Did this really happen?” When the answer is honest, whether the film is shot with a camera or generated by a machine, it does not quarrel with reality; it converses with it.

Reel/irreel: Das traumatische Dilemma der mit Ingenieursleistung einhergehenden Spannung

Die Linie zwischen Wirklichkeit und Bild verlief in zwei verschiedenen Epochen an zwei verschiedenen Orten. Gestern richteten sich Kameras auf den Mond, um den Erfolg zu zeigen; heute werden manche Erfolge von Software erzeugt, die gewissermaßen selbst wie eine Kamera arbeitet. Doch die Grundspannung blieb gleich: Ein großer ingenieurtechnischer Vorstoß ist sowohl reel (mit Geräten messbar, reproduzierbar) als auch irreel (er sprengt das etablierte Denken und lässt fragen: „Wie ist das möglich?“). Diese doppelte Natur ruft in manchen Blicken auf den Erfolg dieselbe Reaktion hervor: „Wenn es menschlich ist, wurde es nicht vollbracht“ oder „wenn es vollbracht wurde, kann es nicht mehr menschlich sein“. Dieser Text stellt die Mondlandung neben die KI-Debatten im Umfeld von Sam Altman und Elon Musk und erklärt klar und einfach, woher diese Reaktion kommt.

Zuerst wird schlicht geklärt, warum die Mondlandung reel ist. Auf der Mondoberfläche wurde Ausrüstung zurückgelassen, und diese Ausrüstung ist noch heute messbar. Dank der von den Astronauten aufgestellten reflektierenden Paneele kehrt ein von der Erde ausgesandter Laserstrahl zurück; über die gemessene Zeit wird die Entfernung Erde–Mond präzise berechnet (🔗). Detaillierte Fotos eines Raumfahrzeugs im Orbit zeigen die Landeplätze und die Spuren (🔗). Das ist ein System, das man einen „Beweis des Beweises“ nennen kann: Ob etwas stattgefunden hat, misst man mit Geräten immer wieder – und erhält dasselbe Ergebnis. Dennoch sagen manche Menschen: „Ich kann dem Bild, das ich sehe, nicht trauen.“ Warum? Weil das Bild eine Welt zeigt, an die das Auge nicht gewöhnt ist: Sterne sind auf dem Foto unsichtbar, Schatten verlaufen in überraschenden Winkeln, die Flagge wirkt gekräuselt, obwohl es keinen Wind gibt. Tatsächlich ist all das Gegenstand einfacher Physik- und Fotografiekenntnisse. Bei sehr hellem Licht verschwinden Sterne in der Kamera; auf unebenem Boden wirken Schatten nicht parallel; öffnet sich die horizontale Stange an der Flagge nicht vollständig, wirft der Stoff Falten. Kommt einem das Bild jedoch auf den ersten Blick „wie ein Studio“ vor, greift der Verstand sofort nach einem praktischen Ausweg: „Dann ist es eben gefälscht.“ So funktioniert Leugnung.

In der Gegenwart stößt man auf das gegenteilige Bild: Nun kann eine Maschine das erzeugen, was echt aussieht. Ein trainiertes Modell nimmt eine Anweisung entgegen, erzeugt ein Video oder ein Foto, und dieses Erzeugnis „wirkt sehr wirklich“. Auch hier gibt es die reale Seite: Diese Systeme arbeiten mit Strom, Daten und Mathematik; man kann prüfen, wiederholen und messen. Doch die irreale Seite ist stärker: Was auf dem Bildschirm erscheint, ist etwas, das „so aussieht, als wäre es geschehen“. Das Auge verliert die gewohnte Zeugenschaft („Da war jemand mit einer Kamera und hat aufgenommen“). Das früher auf der Mondoberfläche zurückgelassene Reflektorpaneel ähnelt heute der „Spur“, die in digitalen Inhalten hinterlassen werden muss: eine Art Ausweis, der die Quelle der Erzeugung und spätere Eingriffe dokumentiert. Das heißt kurz Provenienz; wenn Inhalt erscheint, gibt sie technische Antworten auf die Fragen „Woher kommt er, wer hat ihn erzeugt, was wurde verändert?“. Initiativen wie C2PA versuchen genau das zu etablieren (🔗). Man muss jedoch wissen: Eine Spur zu hinterlassen beseitigt Zweifel nicht vollständig, sondern lenkt ihn nur an die richtige Stelle. Der Mensch hinterfragt nicht den Inhalt selbst, sondern die Kette, die den Inhalt verlässlich macht. Das ist ein gesunder Schritt.

Witze und Legenden der Art „Sie sind keine Menschen“, die Sam Altman und Elon Musk umkreisen, greifen genau hier ein. Figuren, die in außergewöhnlichem Tempo Produkte hervorbringen, Massen beeinflussen und Kapital mit Ingenieurwesen verbinden, lösen schlagartig zwei gegensätzliche Gefühle aus: Bewunderung und Unbehagen. Die Bewunderung ruft „Wow“, das Unbehagen sucht Abkürzungen, um das Selbstwertgefühl zu schützen, und springt zu zwei Ergebnissen: „Ein Mensch kann das nicht, also ist es gefälscht“ oder „wenn er es kann, gehört er ohnehin nicht zu uns“. Scherzhaft gemeinte „Ich bin ein Alien“-Anspielungen bringen zum Schmunzeln, liefern aber zugleich Material für Memes, die dieses Gefühl nähren. Altmans Warnungen, das Internet werde von Bots und künstlichen Inhalten überschwemmt, sowie seine Kommentare, Plattformen fühlten sich „tot“ an, schaffen ebenfalls einen weiteren Kontext, der das Vertrauensproblem vergrößert. Treffen beide Linien aufeinander, ergibt sich dieses Bild: Hier die Geschwindigkeit und Automatisierung, die menschliche Arbeit unsichtbar machen, dort neue Regeln, die einen „Nachweis von Menschlichkeit“ verlangen.

Auch der Begriff „Erfolg“ muss richtig eingeordnet werden. Erfolg ist nicht gleich gut. Die Entwicklung der Atombombe war eine beispiellose ingenieurtechnische Leistung, zog aber eine schwere moralische und menschliche Last nach sich (🔗). Deshalb sind Fragen unverzichtbar: Was wird mit dem Erfolg getan, wem nützt er und bei wem verbleibt das Risiko? Bei der Mondlandung wurde ein Teil dieser Fragen durch Staaten und unabhängige Beobachtungsnetze beantwortet; ein Teil ist bis heute umstritten. Auf der Seite der Künstlichen Intelligenz entspringen aus genau hier Fragen zu Arbeit, Urheberrecht und Einwilligung: Woher stammen Datensätze, wessen Werke dienen dem Training von Modellen, auf welche Weise und mit welcher Erlaubnis werden das Gesicht oder die Stimme einer Schauspielperson kopiert, wie wird Inhalt gekennzeichnet? Je transparenter die Antworten, desto größer das Vertrauen; je unklarer, desto stärker das Gefühl „Wenn es menschlich ist, wurde es nicht vollbracht“.

Wie wird das Dilemma also aufgebrochen? Einige einfache Prinzipien tragen weit. Erstens muss Zeugenschaft neu geschaffen werden. Auf dem Mond wurde sie durch vor Ort zurückgelassene Geräte und unabhängige Beobachtungen hergestellt. Digital entsteht sie durch verlässliche Spuren, die dem Inhalt beigefügt werden, also durch Provenienz. Zweitens sind Wiederholung und Messung entscheidend. Erbringt eine Behauptung über verschiedene Wege dasselbe Ergebnis, wird sie stärker. Drittens müssen Arbeit und Rechte sichtbar sein. Selbst wenn eine Maschine ein Bild erzeugt, müssen die Arbeit der Menschen, die diese Maschine bauen, die Rechte derjenigen, die Daten bereitstellen, und die Einwilligung der dargestellten Personen klar dokumentiert werden. Viertens soll die Sprache schlicht und rechenschaftsfähig sein. Sätze wie „Wir haben dies so gemacht, diese Daten genutzt, hier verändert, hier eine Zustimmung eingeholt“ machen Technik verständlich. Sind diese Prinzipien etabliert, wird Erfolg weder verherrlicht noch verteufelt; er spricht mit dem, was er ist, mit seinen Folgen und seinen Spuren.

Das am Anfang formulierte Dilemma wirkt einfach, ist aber tief. Sehr große, von Menschenhand geschaffene Dinge erscheinen Menschen oft „zu groß“. Dieses Gefühl drängt entweder zum Übersehen oder zur Entmenschlichung. Doch es gibt einen dritten Weg: Verfolge die Spur des Beweises, wiederhole die Messung, mache die Kette transparent, mache Arbeit sichtbar. Was das Reflektorpaneel auf dem Mond leistet, zielt letztlich auf dasselbe wie das Vertrauenssiegel eines Videos auf dem Bildschirm: eine ehrliche Antwort auf die Frage „Ist das wirklich geschehen?“. Fällt die Antwort ehrlich aus, gerät der Film – ob mit Kamera aufgenommen oder von einer Maschine erzeugt – nicht in Streit mit der Wirklichkeit; er tritt mit ihr in ein Gespräch.

[…] (İngilizcesi ve Almancası) […]

LikeLike

[…] Reel/irreel: Mühendislik başarısıyla gelen travmatik ikilem / Real/irreal: The traumatic dilemma that comes with engineering success / Reel/irreel: Das traumatische Dilemma der mit Ingenieursleistung einhergehenden […]

LikeLike